No SciCast #198 (Teoria do Caos, escutem) uma pergunta (ou um pensamento em voz alta) me chamou a atenção: “meteorologia é uma ciência exata”? Não quero entrar no mérito da definição exata de ciências exatas, mas posso dizer com exatidão que o tópico é estudado por físicos, químicos, engenheiros ambientais, entre outros, portanto o classificaria como exatas. No entanto, é praticamente impossível prever exatamente as condições climáticas ou do tráfego na cidade no dia de amanhã. Por que então essas ciências são exatas?

A primeira novidade é essa: as ciências exatas são em geral inexatas. Vamos a primeira razão. Grande parte das ciências exatas utilizam métodos estatísticos; estatística é utilizada quando não temos completo conhecimento de um fenômeno ou quando não temos todos os dados que precisamos. Isto explica a chatice de pesquisa eleitoral com “95% de intervalo de confiança”. Ou seja, é como dizer que “estamos fornecendo números bem exatos, mas há chances de os resultados estarem fora do intervalo descrito”. No entanto percebam que nesse caso a incerteza também é quantificada.

Por outro lado, muito dos fenômenos estudados nas ciências exatas são explicados por modelos matemáticos (isto é, uma série de equações) bem definidos. Muitos deles não apenas com relação estáticas, mas sim dinâmicas. Isto quer dizer que não há uma previsão de temperatura para a cidade de Itajaí-SC para amanhã. Existe um perfil de temperatura para cada instante para cada localidade da cidade. Não apenas isso, a temperatura às 10h05 em um determinado local não deve ser muito diferente da temperatura às 10h10. Similarmente, às 10h05 a temperatura em Itajaí-SC e Gaspar-SC (distante 40km) podem até ser diferentes, porém em geral são parecidas; dificilmente teremos neve em Gaspar e ao mesmo tempo pessoas irão a praia em Itajaí devido ao calor. O fato de o sistema ser dinâmico significa uma “memória” das variáveis relevantes.

Esses modelos dinâmicos são baseados em relações físicas e químicas portanto são aparentemente exatos. Só que não.

Pois então, modelos dinâmicos são estudados e utilizados em diversas aplicações. George Box afirmou que “todos os modelos estão errados; alguns são úteis”. Para a grande maioria dos sistemas, pequenos erros não são críticos e o tratamento de incertezas em geral podem ser negligenciados. Outros, como modelos climáticos, pequenos erros podem se amplificar e levar a previsões completamente diferentes. Neste caso o tratamento de incerteza é fundamental.

Mas raios, então continua imprevisível?

“Erros” ou incertezas podem ter diversas fontes. Modelos dinâmicos necessitam de condições iniciais obtidas por dados de sensores – medidas em geral não são exatas (e para este caso é impossível ter sensores em todos os locais). Já experimentou utilizar dois termômetros para medir a temperatura no mesmo local? Não raro você observará valores diferentes. Isto quer dizer que há inexatidão nas medidas. Isto que a temperatura é relativamente trivial, mas outras medidas são realmente difíceis de medir precisamente como umidade e pressão.

Outra fonte de erro é o modelo matemático em si. Como já comentado, todos os modelos estão errados. Ainda mesmo que não esteja errado, todos os modelos precisam de parâmetros (digamos, o calor específico da água ou a radiação solar incidente) que também não podem ser obtidos com exatidão. Por exemplo, se eu quero estimar a altura de um objeto que caiu baseado no seu tempo de queda eu preciso da aceleração da gravidade, g. Se eu utilizar um valor diferente da aceleração da gravidade, meu modelo é perfeito, mas há erros introduzidos pelos valores do parâmetros.

E qual a solução?

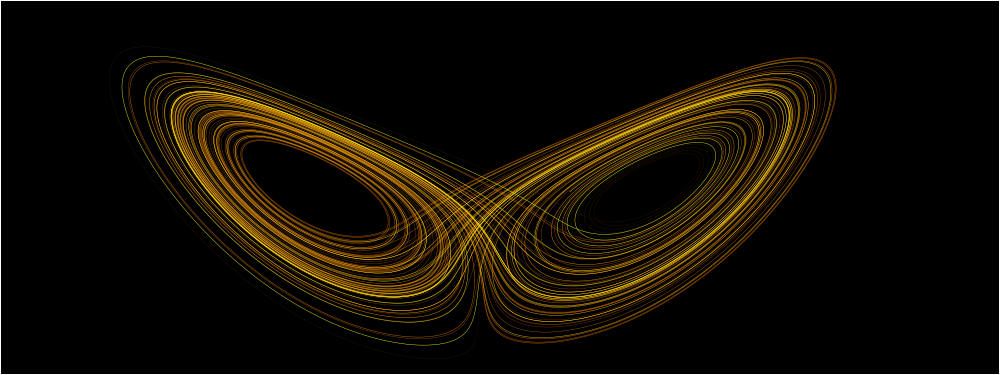

Existem algumas formas de lidar com sistemas deste tipo e no seguinte exemplo a ideia de Filtro de Kalman por Conjunto (“Ensemble Kalman Filter”) e suas variações (às vezes são apenas “Ensemble” sem o Kalman Filter ao final – de fato podem ser coisas diferentes; em geral técnicas similares são chamadas de método “Monte Carlo”). A ideia é, em vez de ter uma única “previsão”, se cria um conjunto de previsões e em cada uma delas você modifica certas grandezas em função de sua incerteza. Por exemplo, se nossa temperatura inicial é de 27°C, mas meu sensor tem erros de +- 2°C eu posso criar elementos do conjunto com temperaturas entre 25°C e 29°C e analisar os possíveis resultados.

Um exemplo eu coloco na Figura abaixo. Existe uma temperatura inicial (incerta) e a tendência é ir a uma temperatura de equilíbrio. Porém a temperatura de equilíbrio é 15° C se a temperatura está abaixo de 22° C e de 35° C se está acima deste valor (Isto é apenas um exemplo didático – não tirei de nenhum modelo climático) . A cada instante a variação de temperatura é adicionada de uma variável randômica representando nossa ignorância da realidade. Cada linha tracejada é uma possível trajetória. Veja que o “Caos”, como discutido no SciCast 198, é a temperatura de limiar 22° C (22.000001 é bem diferente de 21.99999!), isto é, sensibilidade quanto a pequenos erros nas condições iniciais. A saída do modelo determinístico (isto é, sem variáveis aleatórias) é a linha contínua preta. Veja que ela é útil, mas apenas analisando-a não saberíamos que existe uma possibilidade, ainda que pequena, de termos altas temperaturas.

Em certos domínios, este tipo de técnica vem sendo utilizada. Isto é realmente útil quando a trajetória central (ou determinística) não contém todas as informações relevantes. Veja que se não houvesse o conjunto superior na figura (as poucas trajetórias que convergem para temperaturas superiores a 30°C) poderíamos dizer que a linha contínua é o centro da predição e poderíamos adicionar uma margem de erro e isto seria suficiente.

No caso de tráfego, por exemplo, existem médias de demanda, mas o número exato de veículos a cada instante não sabemos. Mesmo que soubéssemos, cada motorista se comporta diferentemente, de forma que não é trivial estimar o congestionamento amanhã no horário de pico mesmo conhecendo exatamente a demanda.

É com esse tipo de técnica que agora verificamos a previsão de tempo na internet e não há mais “previsão de chuva”, mas sim uma probabilidade de chuva. A grosso modo, o significado é o seguinte: temos 50000 trajetórias possíveis para o clima; destas, 5000 em determinado local irá chover portanto a probabilidade de chuva é de 10%.

Como curiosidade, o CPTEC é listado no verbete da Wikipedia por utilizar “Ensemble Forecasting” assim como diversos centros meteorológicos. Isto também é aplicado em outros sistemas geofísicos – o Ensemble Kalman Filter foi desenvolvido em uma pesquisa em oceanografia. Este tipo de técnica também é utilizados para previsão de fluxo em rios; e veja que em vez de a informação de “vai ter enchente ou não vai ter enchente” o que se obtém são probabilidades: “há uma chance de 12% de ter enchente no final de semana”.

Isto é exato?

Claramente isto não é “exato”, afinal já sabemos de antemão que há incertezas e isto não é exato. No entanto todos os passos são claramente quantitativos. Neste caso até as incertezas são quantificadas portanto isto deve justificar o rótulo de “exatas”.

Referências

Felipe de Souza Doutorando tentando ser o menor culpado pelo excesso de trânsito em sua cidade